保姆级实操!用白嫖方案解决 DeepSeek"服务器繁忙"卡成狗的问题

大家好,我是工会代表。

最近圈里都在刷屏"国产之光 DeepSeek",但用过的小伙伴都知道——这货是真!的!卡!动不动就给你弹"服务器繁忙,请稍后再试",简直能把人逼疯。

官方网页版和 App 的响应速度...这么说吧,10 条回复里有 8 条能卡成 PPT。作为日聊 200+条的重度用户,我差点被这延迟整出高血压。

有小伙伴要问了:DeepSeek 这么牛逼的大模型,体验咋这么拉胯?

大实话时间:DeepSeek 团队主攻 AGI,人家精力全砸在模型研发上。要指望他们优化 C 端服务?就跟让马斯克去开滴滴一样——专业不对口!

一、暴力破解方案选择

重点来了!DeepSeek R1 是开源的,这就意味着...

两大破局姿势:

- 本地部署(土豪专属)

- 第三方云服务(真香选择)

先说本地部署:模型参数 671B,显存需求直接飙到 1000G+!就算你搞来 8 张 A100 显卡,电费都能让你怀疑人生。至于简化版 1.5b 模型?性能和原版比就像五菱宏光 vs 超跑。

所以今天重点安利白嫖组合拳:硅基流动+Chatbox AI(亲测响应速度<3 秒)

二、手把手教学时间

Step1:注册硅基流动(薅羊毛环节)

访问硅基流动官网,用手机号注册时记得填我邀请码 XvkoM1qA(白嫖 14 元额度,双赢!)

注册后直奔【API 密钥】页面,点击新建密钥:

复制生成的密钥(别外泄!)

Step2:配置 Chatbox AI(灵魂注入)

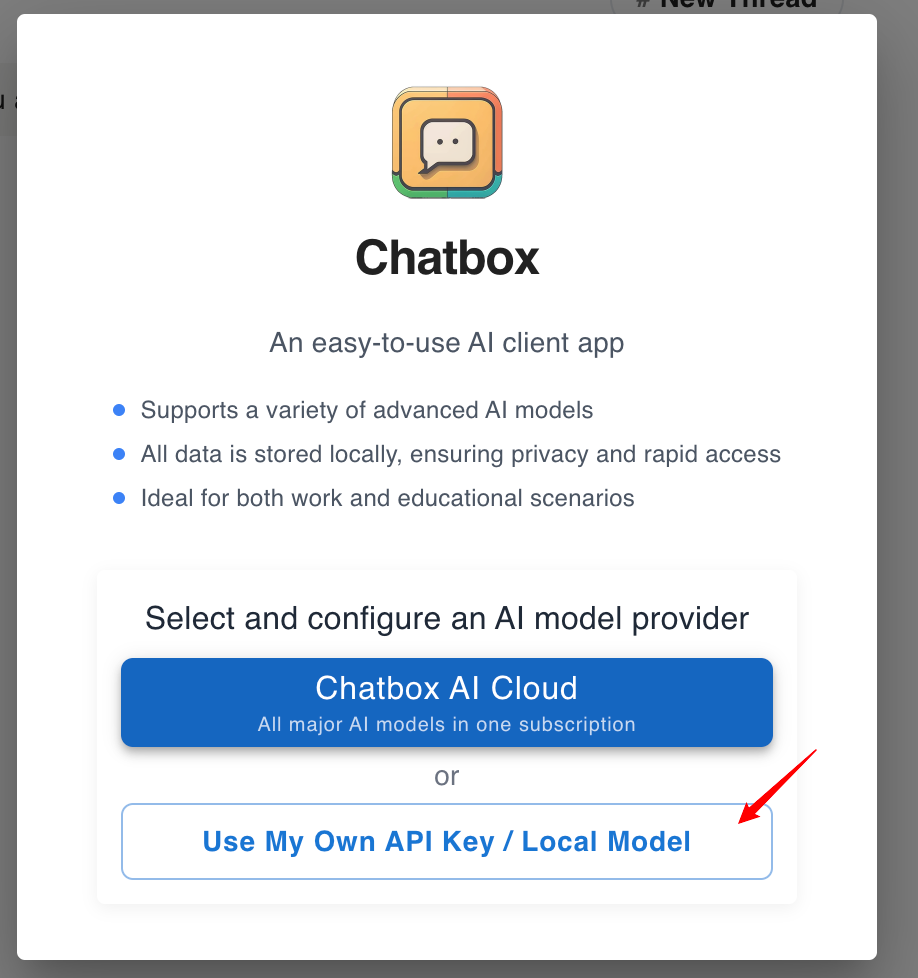

到Chatbox 官网下载客户端,安装时选"使用自己的 API Key":

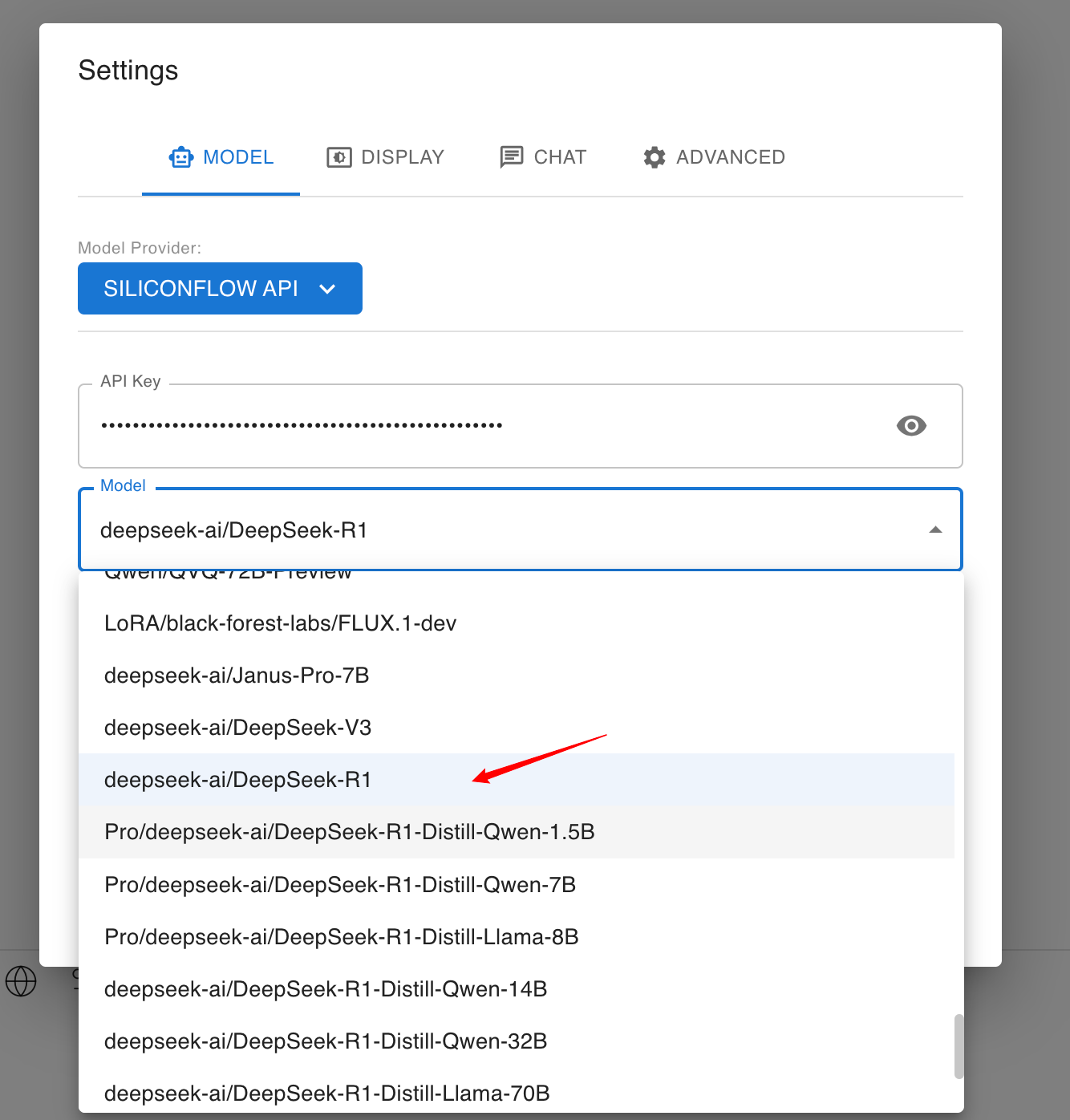

在设置里找到 SiliconFlow API 选项,粘贴刚复制的密钥,选择 DeepSeek R1 模型:

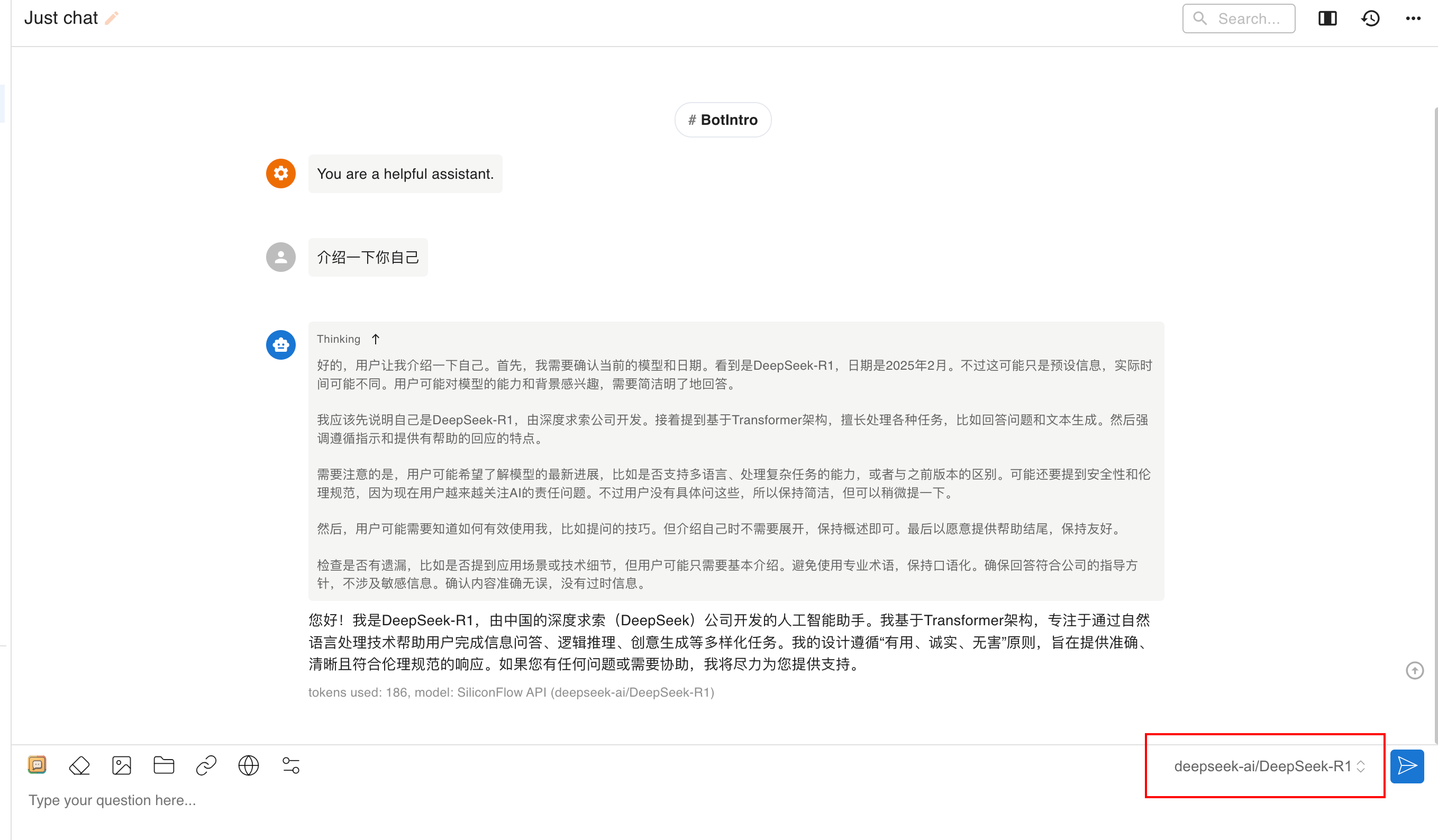

Step3:速度测试(见证奇迹)

输入"介绍一下你自己",感受丝滑响应:

对比官方网页版,这速度简直就像 5G 秒杀 2G!

三、备选方案(摸鱼指南)

如果不想折腾,这些平台已内置 DeepSeek R1:

- 国家超算互联网:chat.scnet.cn

- 秘塔 AI 搜索:metaso.cn

- 纳米 AI 搜索:n.cn